Sự bùng nổ của AI đã lan tỏa đến mức Raspberry Pi Foundation vừa mới ra mắt AI Hat+ add-on. Tuy nhiên, bạn không cần phần cứng chuyên dụng để chạy các mô hình AI trên Raspberry Pi cục bộ. Bạn hoàn toàn có thể chạy các mô hình ngôn ngữ nhỏ trên bo mạch Raspberry Pi của mình bằng CPU. Mặc dù việc tạo token chắc chắn sẽ chậm, nhưng vẫn có những mô hình triệu tham số nhỏ hoạt động khá tốt. Dưới đây là hướng dẫn chi tiết cách chạy các mô hình AI trên Raspberry Pi, tối ưu cho người dùng Việt Nam.

Contents

Yêu Cầu Phần Cứng và Phần Mềm

Để có trải nghiệm tốt nhất, bạn cần:

- Một chiếc Raspberry Pi với ít nhất 2GB RAM. Raspberry Pi 4 với 4GB RAM là lựa chọn lý tưởng. Một số người dùng thậm chí đã thành công trong việc chạy các mô hình AI trên Raspberry Pi Zero 2 W chỉ với 512MB RAM.

- Một thẻ microSD với ít nhất 8GB dung lượng lưu trữ.

- Kết nối internet ổn định.

Cài Đặt Ollama Trên Raspberry Pi

Ollama là một công cụ giúp đơn giản hóa việc tải xuống và chạy các mô hình ngôn ngữ lớn (LLM) trên máy tính của bạn, bao gồm cả Raspberry Pi.

-

Thiết lập Raspberry Pi: Nếu bạn chưa thiết lập Raspberry Pi của mình, hãy tham khảo hướng dẫn cách thiết lập Raspberry Pi mà không cần màn hình hoặc cáp Ethernet.

-

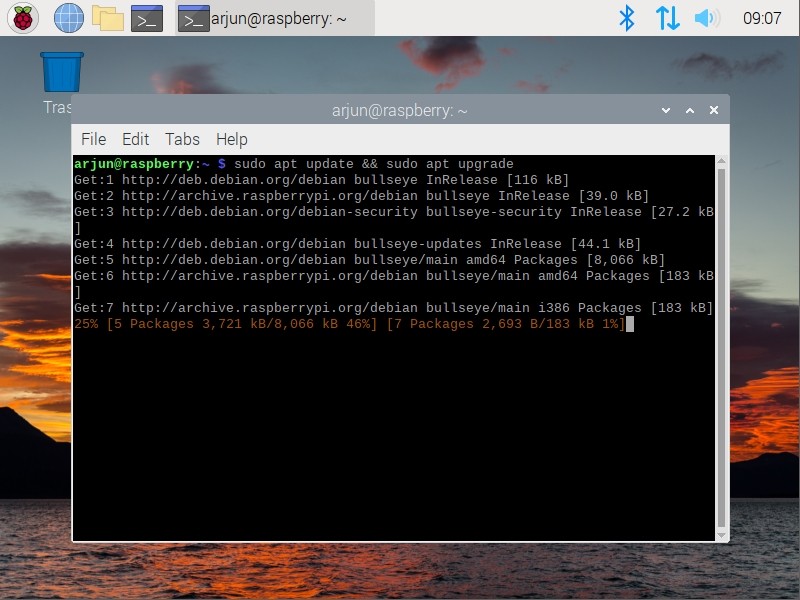

Cập nhật gói và thư viện: Mở Terminal và chạy lệnh sau để cập nhật tất cả các gói và thư viện phụ thuộc:

sudo apt update && sudo apt upgrade Cập nhật các gói trên terminal của Raspberry Pi

Cập nhật các gói trên terminal của Raspberry Pi

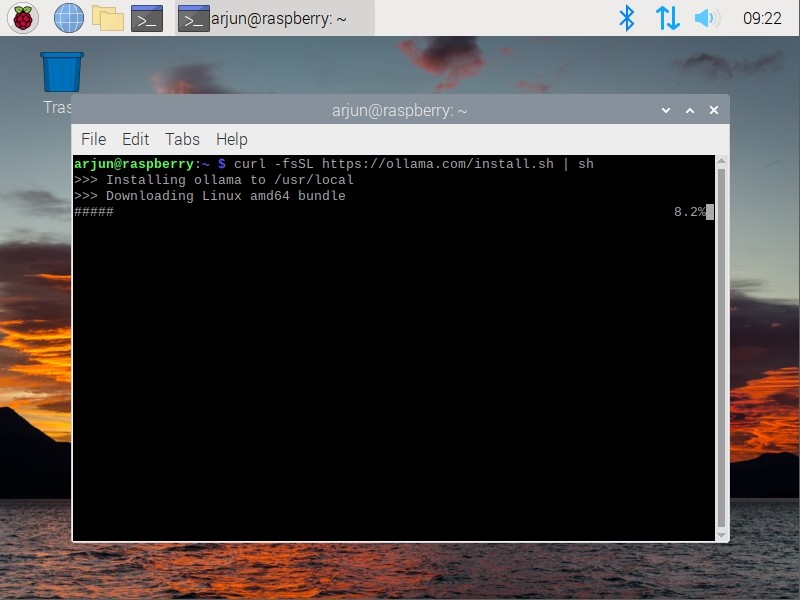

- Cài đặt Ollama: Chạy lệnh sau để cài đặt Ollama trên Raspberry Pi của bạn:

curl -fsSL https://ollama.com/install.sh | sh Cài đặt Ollama trên Raspberry Pi

Cài đặt Ollama trên Raspberry Pi

- Xác nhận cài đặt: Sau khi Ollama được cài đặt, bạn sẽ nhận được một cảnh báo rằng nó sẽ sử dụng CPU để chạy mô hình AI cục bộ. Điều này là bình thường đối với Raspberry Pi.

Chạy Các Mô Hình AI Cục Bộ Trên Raspberry Pi

Sau khi cài đặt Ollama, bạn có thể dễ dàng chạy các mô hình AI khác nhau. Dưới đây là một vài ví dụ:

- Chạy TinyLlama: Mô hình TinyLlama là một LLM nhỏ gọn, phù hợp để chạy trên Raspberry Pi. Để chạy nó, hãy sử dụng lệnh sau:

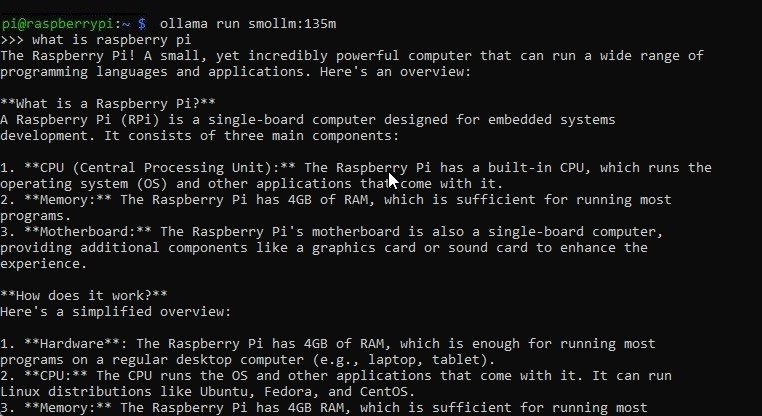

ollama run tinyllama- Chạy Smollm: Smollm là một mô hình thậm chí còn nhỏ hơn, chỉ với 135 triệu tham số và tiêu thụ 92MB bộ nhớ. Đây là một lựa chọn tuyệt vời cho Raspberry Pi:

ollama run smollm:135m Smollm chạy trên Raspberry Pi

Smollm chạy trên Raspberry Pi

- Chạy Phi: Để chạy mô hình Phi, sử dụng lệnh:

ollama run phiSau khi mô hình AI được cài đặt, hãy nhập câu lệnh của bạn và nhấn Enter. Quá trình tạo phản hồi sẽ mất một chút thời gian.

Trong quá trình thử nghiệm, Raspberry Pi 4 tạo ra các phản hồi với tốc độ chậm, nhưng đó là điều bạn nhận được trên một máy tính bảng đơn nhỏ bé.

Mẹo và Thủ Thuật Để Tối Ưu Hiệu Suất

- Chọn mô hình phù hợp: Các mô hình nhỏ hơn sẽ chạy nhanh hơn trên Raspberry Pi. Hãy thử nghiệm với các mô hình khác nhau để tìm ra mô hình phù hợp nhất với nhu cầu của bạn.

- Tăng RAM (nếu có thể): Nếu bạn có thể tăng dung lượng RAM của Raspberry Pi, điều này sẽ cải thiện hiệu suất đáng kể.

- Sử dụng SSD: Thay vì sử dụng thẻ microSD, hãy sử dụng ổ SSD để tăng tốc độ đọc/ghi dữ liệu.

- Ép xung: Ép xung Raspberry Pi có thể giúp tăng hiệu suất, nhưng hãy cẩn thận để không làm quá nhiệt thiết bị.

- Tắt các ứng dụng không cần thiết: Đóng tất cả các ứng dụng không cần thiết để giải phóng tài nguyên cho mô hình AI.

Các Ứng Dụng Thực Tế Của AI Trên Raspberry Pi

Chạy các mô hình AI trên Raspberry Pi mở ra nhiều khả năng thú vị:

- Trợ lý ảo cá nhân: Xây dựng một trợ lý ảo có thể điều khiển các thiết bị thông minh trong nhà, trả lời câu hỏi và thực hiện các tác vụ khác.

- Xử lý ngôn ngữ tự nhiên: Phân tích văn bản, dịch ngôn ngữ và tạo nội dung.

- Nhận dạng hình ảnh: Nhận dạng các đối tượng trong ảnh và video.

- Robot học: Điều khiển robot và các thiết bị tự động khác.

- Giáo dục: Sử dụng AI để tạo ra các trải nghiệm học tập cá nhân hóa.

1. Raspberry Pi nào phù hợp nhất để chạy các mô hình AI?

Raspberry Pi 4 với ít nhất 4GB RAM là lựa chọn tốt nhất để có trải nghiệm mượt mà. Tuy nhiên, bạn vẫn có thể thử nghiệm trên các phiên bản Raspberry Pi Zero 2 W với 512MB RAM, nhưng hiệu suất sẽ hạn chế hơn.

2. Tôi có thể chạy những loại mô hình AI nào trên Raspberry Pi?

Bạn có thể chạy nhiều loại mô hình AI, đặc biệt là các mô hình ngôn ngữ nhỏ (LLM) như TinyLlama, Smollm và Phi. Các mô hình này được thiết kế để hoạt động hiệu quả trên các thiết bị có tài nguyên hạn chế.

3. Ollama là gì và tại sao nó lại hữu ích cho Raspberry Pi?

Ollama là một công cụ giúp đơn giản hóa việc cài đặt và chạy các mô hình ngôn ngữ lớn trên Raspberry Pi. Nó giúp bạn dễ dàng tải xuống, quản lý và chạy các mô hình AI mà không cần phải lo lắng về các vấn đề phức tạp về cấu hình.

4. Làm thế nào để cải thiện hiệu suất khi chạy AI trên Raspberry Pi?

Để cải thiện hiệu suất, bạn có thể chọn các mô hình AI nhỏ gọn, tăng dung lượng RAM (nếu có thể), sử dụng ổ SSD thay vì thẻ microSD, ép xung Raspberry Pi (cẩn thận để không làm quá nhiệt), và tắt các ứng dụng không cần thiết.

5. Các ứng dụng thực tế của việc chạy AI trên Raspberry Pi là gì?

Việc chạy AI trên Raspberry Pi mở ra nhiều ứng dụng thú vị, bao gồm trợ lý ảo cá nhân, xử lý ngôn ngữ tự nhiên, nhận dạng hình ảnh, robot học và giáo dục cá nhân hóa.

6. Tôi có cần kết nối internet để chạy các mô hình AI trên Raspberry Pi không?

Bạn cần kết nối internet để tải xuống các mô hình AI ban đầu. Tuy nhiên, sau khi mô hình đã được tải xuống, bạn có thể chạy nó cục bộ trên Raspberry Pi mà không cần kết nối internet.

7. Có những framework nào khác ngoài Ollama để chạy AI trên Raspberry Pi?

Có, một framework phổ biến khác là Llama.cpp. Tuy nhiên, quá trình cài đặt Llama.cpp có thể phức tạp hơn so với Ollama.

Kết luận

Với Ollama, việc chạy các mô hình AI trên Raspberry Pi trở nên dễ dàng hơn bao giờ hết. Mặc dù hiệu suất có thể không bằng các máy tính mạnh mẽ hơn, nhưng Raspberry Pi vẫn là một nền tảng tuyệt vời để thử nghiệm và học hỏi về AI.

Gần đây, tôi đã sử dụng Raspberry Pi để tạo ra một thiết bị Android Auto không dây, vì vậy nếu bạn quan tâm đến các dự án thú vị như vậy, hãy xem hướng dẫn của chúng tôi.